Source

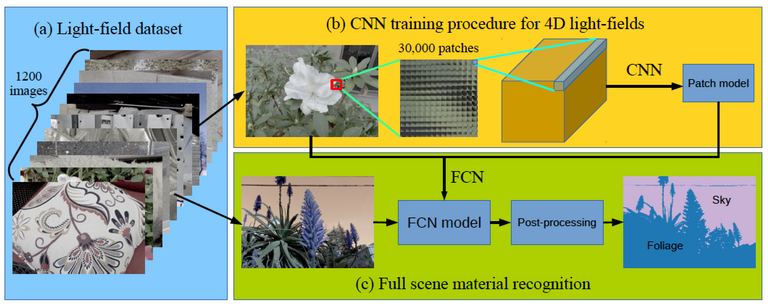

Even the dumbest of humans is capable of understanding the 3D structure of a 2D printed image, but machines, no matter how much AI is applied to them, do not care as well, although the use of neural networks has greatly improved this situation the results are not fast enough for all real world applications.

Hasta el más tonto de los humanos es capaz de comprender la estructura 3D de una imagen impresa en 2D pero a las máquinas por mucha IA que se les aplique no se les da igual de bien, aunque el uso de redes neuronales ha mejorado mucho esta situación los resultados no son lo suficientemente rápidos para todas las aplicaciones del mundo real.

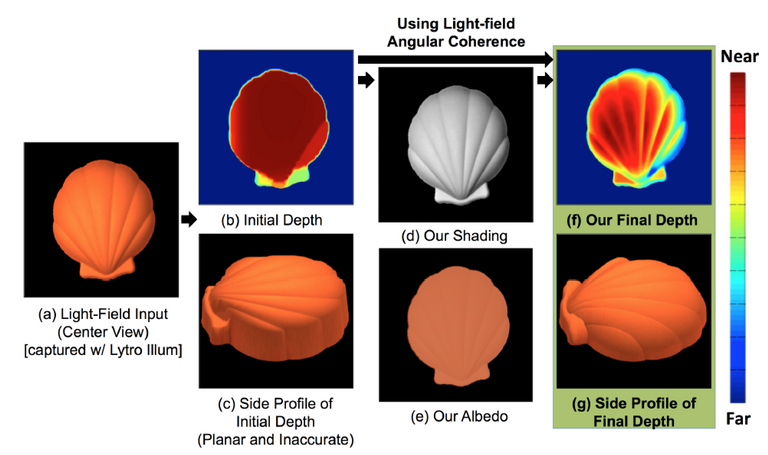

To render a 3D object from a 2D image requires mapping thousands of light rays that "come out" from the camera and hit each of the image pixels to detect its color and deduce the depth of the image from it, for this process the current methods take thousands of samples along the "beam" but that requires a lot of processing power which leads to a very slow rendering.

Para renderizar un objeto 3D a partir de una imagen 2D se requiere mapear miles de rayos de luz que "salen" de la cámara y golpean cada uno de los píxeles de la imagen para detectar su color y deducir de éste la profundidad de la imagen, para este proceso los métodos actuales toman miles de muestras a lo largo del "rayo" pero eso requiere mucha capacidad de proceso lo que conlleva un renderizado muy lento.

Source

However, the reality is that robots and machines need to have a three-dimensional view of the environment in order to be effective, so the traditional system is not very useful and we need to find more effective methods to correct this problem, that is precisely what they have done a group of MIT engineers.

Sin embargo la realidad es que los robots y las máquinas necesitan tener una visión tridimensional del entorno para poder ser efectivos por lo que el sistema tradicional no resulta muy útil y necesitamos encontrar métodos más eficaces para subsanar este problema, eso precisamente es lo que han hecho los ingenieros del MIT.

These are the so-called light field networks (LFN) that are capable of rendering a 3D image from a single 2D image practically in real time, for this the system uses the so-called Plückerian coordinates, a reference system that allows operating with the points of infinity as with any other point in Euclidean space.

Se trata de las llamadas redes de campo de luz (LFN) que son capaces de renderizar una imagen 3D a partir de una sola imagen 2D prácticamente en tiempo real, para esto el sistema utiliza las llamadas coordenadas Plückerianas, un sistema de referencia que permite operar con los puntos del infinito como con cualquier otro punto del espacio euclídeo( el de toda la vida).

Source

To test the system, the scientists reconstructed 360º light fields from several simple images and realized that the networks of light fields were capable of 3D rendering of these images at a speed of 500 frames per minute, that is three orders of magnitude faster than standard procedures.

Para probar el sistema los científicos reconstruyeron campos de luz de 360º de varias imágenes simples y se dieron cuenta de que las redes de campos de luz eran capaces de hacer el renderizado 3D de estas imágenes a una velocidad de 500 fotogramas por minuto, esto es tres órdenes de magnitud más rápido que los procedimientos habituales.

In addition to getting more clarity in the renderings, the system only requires 1.6 Mb of storage compared to the 146 Mb used by the previous methods, so it suddenly occurs to me that this system can give a good boost to virtual reality that is so necessary to be able to fully enjoy the metaverses.

Además de conseguir más nitidez en los renderizados el sistema solo requiere 1,6 Mb de almacenamiento frente a los 146 Mb utilizados por los métodos anteriores, así de pronto se me ocurre que este sistema puede dar un buen empujón a la realidad virtual que tanto nos hace falta para poder disfrutar a tope de los metaversos.

More information/Más información

https://news.mit.edu/2021/3-d-image-rendering-1207

Your content has been voted as a part of Encouragement program. Keep up the good work!

Use Ecency daily to boost your growth on platform!

Support Ecency

Vote for new Proposal

Delegate HP and earn more

Esto generaría simulaciones en las que no podríamos distinguirlas de la realidad.

Así es querida amiga, por eso hay quien piensa que vivimos en una simulación.

El día que nosotros los consigamos quien te asegura que somos los primeros de la cadena?. :-P

Hola @mauromar, ahora los mundos virtuales serán de mejor calidad.