之前写过一篇文章三分钟在本地运行DeepSeek R1推理模型,总结一下其实就是两句话,下载安装Ollama,拉取并使用对应的模型(比如deepseek-r1:8b)。

(图源 :pixabay)

不过这样安装以后,对面界面是黑乎乎的命令行窗口,想往上翻对话记录也非常难,复制粘贴也非常不方便,如果系统再渣一点,模型反应慢,那简直就是折磨呀。

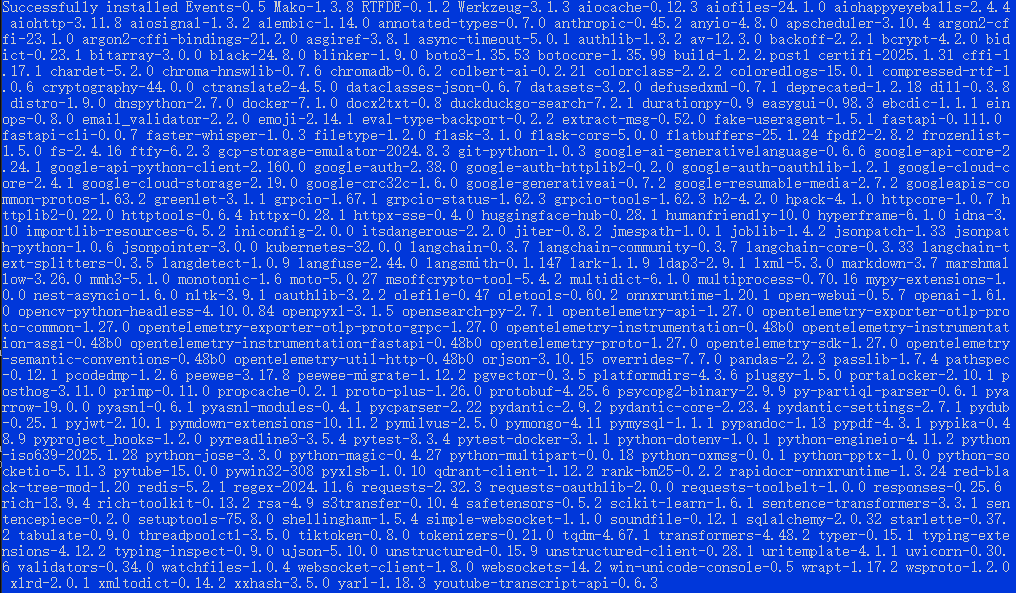

比如下边这个问答界面,先不管回答问题的质量,光看界面,就问你晕不晕,反正我是晕了!

你可以会好奇,问题中怎么还出现了.....,那是因为还有一句话,现在,打开阀门,请问被挤到屏幕的右边了,囧!

那么有没有办法,让本地部署的DeepSeek R1,至少在界面上,使用方便性上和ChatGPT一样好用呢?答案当然是有的,那就是给DeepSeek R1加上一个WebUI。

使用哪种WebUI呢?我查了一下有不下十几种方案,不过被使用最多的貌似就是Open WebUI,那咱也别折腾别的啦,就选择这个吧。

不过貌似安装和配置Open WebUI也不是那么简单?比如网上很多方案都是使用Docker安装的,而我对Docker一无所知😳。那有没有什么适合我的方法呢?翻来翻去,发现一条指令:

pip install open-webui

不用多,就这一条指令就可以搞定Open WebUI安装。不过不知道我告诉你这一条指令足足弄了一宿还多次以失败告终,你会不会气馁呢?而失败的原因嘛,那就是因为网速!

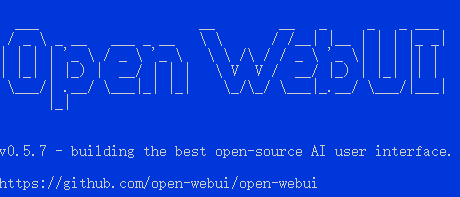

第二天一早,继续运行这个指令,安装搞定了,来让你看看一条指令在我电脑里装了多少东西?

噗,具体有多少东西,反正我是数不过来了,也不打算数了。接下来是见证奇迹的时刻了,运行一下Open WebUI:

open-webui serve

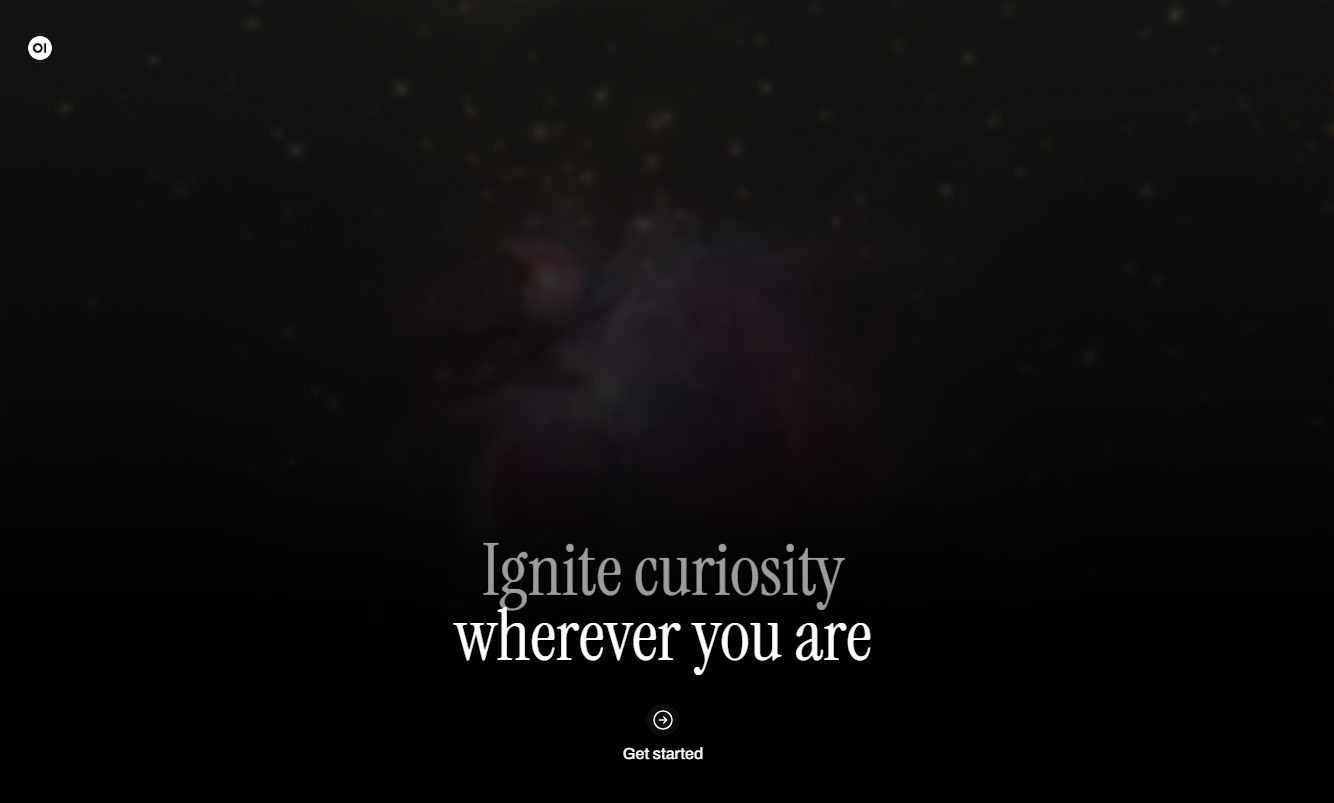

然后噗噗噗一通输出后,它就运行起来啦:

接下来,在浏览器中输入如下网址:

http://localhost:8080

如果一切正常,会打开如下页面:

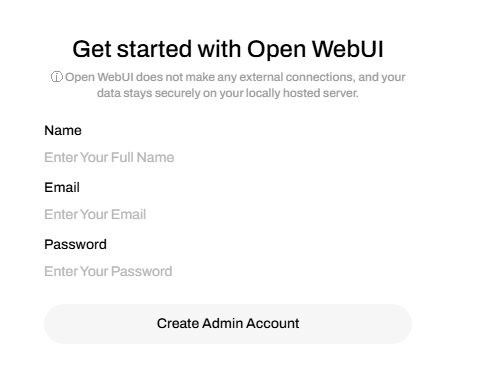

点击上边页面的底部,Get Started,创建一个管理员账户:

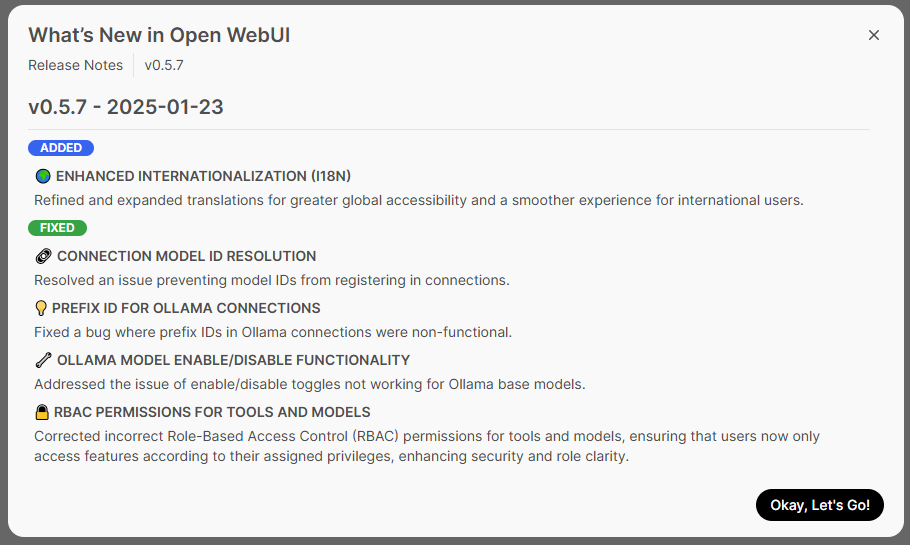

弹出的提示信息,可以直接关闭

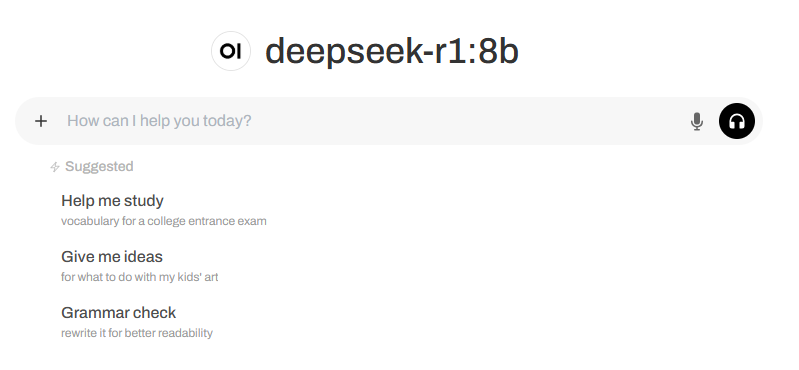

如果你之前已经成功的安装了Ollama以及相应的模型,那么将直接可以工作:

是不是很熟悉,没错,看起来和ChatGPT的对话窗口一样一样的,简直不要太方便。

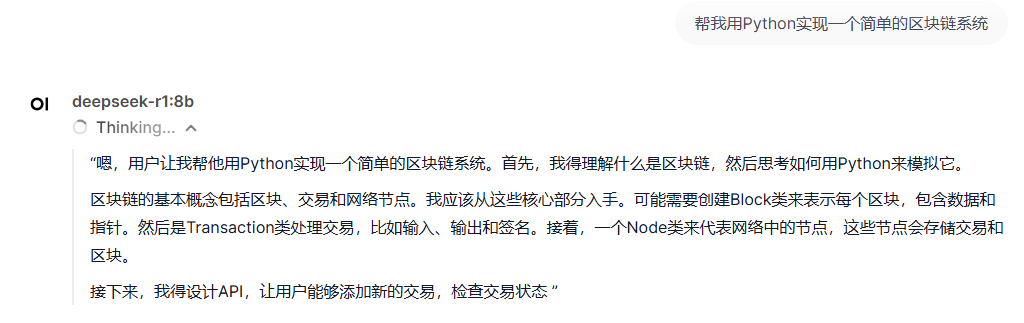

让我来体验一下:

这是其中的部分代码:

哦买噶,我是不是可以发币割韭菜了?哎,算了,韭菜何苦为难韭菜!

强大!

纯水回复🤣 那天某用户还创造AI自动回复评论帖子,我看很快已经分不出是人还是鬼恢复了。说不定很快又如欧胸上面说,分分钟AI自行发币上链了。

配置太差了跑不动,连8b的都不一定能跑。满血那玩意是600多B的。

我真的不喜欢技术,因为它会让我感到困惑,而您是超自然的。

太厉害了,难怪说R1甚至超越GPT,但是对于我们这些代码小白来说,还是比较有难度,暂时只能限于手机APP上使用,哈哈

👍👍

好及时的分享,感谢🫡

O哥大年初八发发发!🧧🧧🧧🧧🧧🧧🧧🧧🧨🧨🧨🧨🧨🧨🧨🧨

@tipu curate 7

Upvoted 👌 (Mana: 0/64) Liquid rewards.

O婶威武,国产之光!